Quand l’émotion viendra aux robots

, Directeur IIM & Chercheur Intelligence Artificielle, Pôle Universitaire Léonard de Vinci, sur The Conversation France.

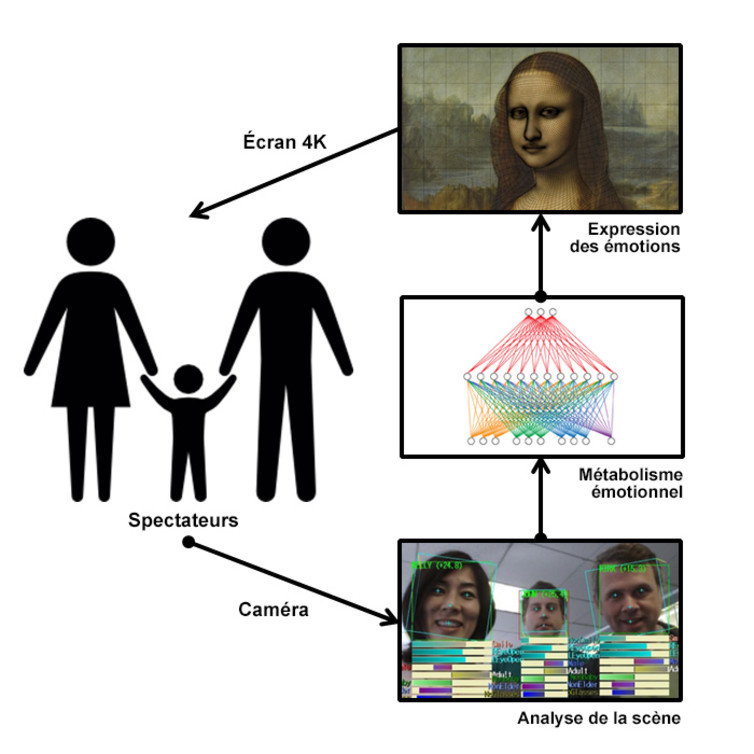

En illustration : « La living Joconde » est capable d’exprimer des émotions en fonction du comportement des spectateurs tout en respectant les intentions de l’œuvre de Léonard de Vinci. Ce projet est le fruit d’un partenariat entre l’Institut de l’Internet et du Multimédia (IIM), de Strate — École de Design, et de Florent Aziosmanoff (auteur). Il a été financé en partie par la région Île-de-France.

Lorsque l’on demande à quelqu’un quelle est la différence entre l’homme et la machine, bien souvent, la réponse est que la machine est incapable de ressentir des émotions.

Pourtant, on voit de plus en plus de robots exprimer des émotions. On parle même pour certains de robots émotionnels… Mais sont-ils réellement capables de ressentir des émotions ? Un robot peut-il se mettre en colère ou tomber amoureux ? Un robot peut-il avoir mal ou, au contraire, éprouver du plaisir ?

Pour tenter de répondre à ces questions, il convient de distinguer trois aspects :

- La capacité d’exprimer des émotions

- Celle de percevoir les émotions exprimées par les autres

- Celle de ressentir soi-même des émotions.

Ces trois facettes sont nécessaires pour qu’une entité, organique ou artificielle, puisse être qualifiée de créature émotionnelle.

La capacité d’exprimer des émotions est celle qui est la plus maîtrisée aujourd’hui. Depuis les travaux de Charles Darwin et ceux de Paul Ekman, pour ne citer que les plus connus, nous savons qu’il existe des expressions émotionnelles universelles. Toute l’histoire de l’art et celle plus récente de l’animation montrent que nous sommes capables de créer des personnages artificiels qui expriment parfaitement ces émotions. Il en est aujourd’hui de même avec les créatures artificielles, par exemple dans les jeux vidéo, et bien sûr avec les robots.

La seconde capacité correspond à celle de percevoir les émotions. Il s’agit d’être capable de capter et d’interpréter les signaux comportementaux et verbaux qui témoignent de l’état émotionnel de son interlocuteur.

Là encore, nous avons fait des progrès importants ces dernières années, en particulier grâce aux avancées dans le domaine de l’apprentissage profond (Deep Learning). En analysant les expressions faciales, la tonalité de la voix et le contenu des messages verbaux, il est possible d’en déduire l’état émotionnel d’une personne.

Métabolisme émotionnel

La troisième capacité est celle de ressentir (réellement) des émotions. Les humains possèdent un métabolisme émotionnel complexe faisant intervenir de nombreuses régions du cerveau dont le système limbique. À l’inverse, les machines ne possèdent aucun métabolisme émotionnel. Il est bien sûr possible de simuler un tel système, comme nous l’avons fait dans le projet Living Joconde par exemple. Néanmoins, il s’agit d’une simulation et non d’un véritable dispositif permettant de ressentir à proprement parler des émotions.

La boucle d’interaction émotionnelle de la Living Joconde est constituée par un capteur capable de percevoir le comportement des spectateurs, un métabolisme émotionnel bioinspiré utilisant un modèle connexionniste, et une infographie en image synthèse de très haute définition animée en temps réel.

En effet, l’homme est doté non seulement d’un système sophistiqué de perception externe (les cinq sens classiques), mais aussi de perception interne. Le cerveau est hyperconnecté au corps par un réseau qui nous permet de ressentir avec acuité l’ensemble de notre corps.

Prenons l’exemple d’une sensation comme la douleur (nous nous limiterons ici à la douleur physique), qui n’est certes pas une émotion à proprement parler, mais qui a un impact direct sur la biochimie émotionnelle du cerveau. Nous percevons les agressions physiques au travers d’un réseau dense de nocicepteurs qui détectent les stimuli potentiellement douloureux pour transmettre l’information à l’encéphale.

Les robots, et plus généralement les machines, ne possèdent aucun système similaire. On notera d’ailleurs que les robots actuels ne sont dotés que d’un nombre relativement restreint de capteurs internes. Dans la plupart des cas, un robot ne peut donc pas percevoir la « limite » entre son propre corps et l’environnement ni « sentir » directement une quelconque agression physique. Par conséquent, il ne peut y avoir en pratique l’émergence d’une conscience de soi ni de véritables sensations émotionnelles primaires ou d’ordre supérieur.

Cela ne signifie pas qu’il soit impossible d’envisager une machine capable de ressentir des émotions. Mais cet objectif, si cela devait en être un, est encore hors de portée. Il faudrait pour cela imaginer des architectures radicalement différentes. Que serait alors la douleur ou le plaisir pour une machine ? La question reste encore sans réponse.

Cela ne signifie pas qu’il soit impossible d’envisager une machine capable de ressentir des émotions. Mais cet objectif, si cela devait en être un, est encore hors de portée. Il faudrait pour cela imaginer des architectures radicalement différentes. Que serait alors la douleur ou le plaisir pour une machine ? La question reste encore sans réponse.

Simulation amoureuse

En guise de conclusion, s’il est parfaitement possible de concevoir des robots capables d’interagir avec nous émotionnellement, avec un réalisme parfois saisissant, ils ne sont en aucun cas capables de ressentir réellement des émotions : un humain peut tomber amoureux d’un robot et « projeter » sur lui ses propres sentiments, mais un robot, lui, ne pourra tout au plus que simuler un comportement amoureux…

Toutefois, le thème des émotions artificielles est un sujet qui devrait devenir crucial dans les années qui viennent. Avec le développement des robots et des assistants virtuels, la question d’une interaction émotionnelle va devenir prépondérante.

D’une part, une meilleure gestion des émotions est un facteur d’amélioration des interactions entre les machines et les hommes, ces derniers étant par nature des êtres sociaux qui ont une tendance naturelle à communiquer « socialement » avec tout ce les entourent, personnes, animaux domestiques, mais aussi avec les machines. D’autre part, l’émotion est synonyme d’adhésion et d’engagement. Et cela, toutes les marques l’ont compris.

En savoir plus sur Jean-Claude Heudin

Article initialement publié sur le site theconversation.com

Informations mises à jour le 30 Juil 2021